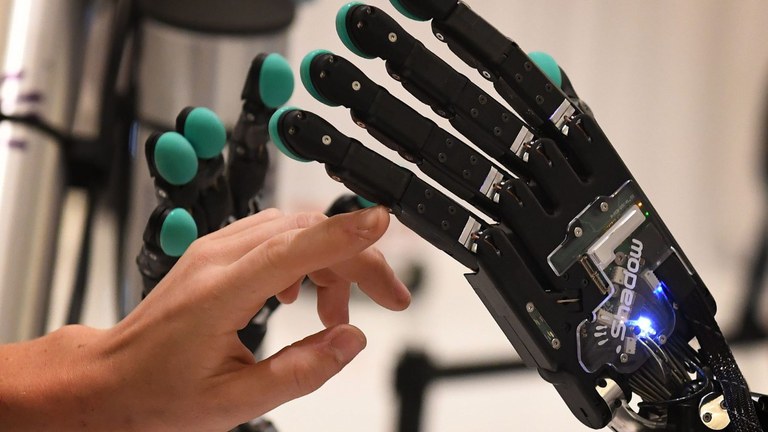

La Santa Sede: IA opportunità, ma l’uomo può diventare schiavo delle macchine

Non va considerata come una persona l’Intelligenza Artificiale, non va divinizzata, non deve sostituire le relazioni umane, ma deve essere utilizzata “solo come strumento complementare all’intelligenza umana”. I moniti del Papa sull’IA di questi ultimi anni fanno da traccia ad Antiqua et Nova, la nota sul rapporto tra Intelligenza Artificiale e Intelligenza umana frutto della mutua riflessione tra Dicastero per la Dottrina della Fede e Dicastero per la Cultura e l’Educazione (LEGGI QUI IL TESTO INTEGRALE DELLA NOTA "ANTIQUA ET NOVA"). Un documento rivolto a genitori, insegnanti, preti, vescovi e quanti sono chiamati a educare e trasmettere la fede, ma anche a coloro che condividono l’esigenza di uno sviluppo scientifico e tecnologico “al servizio della persona e del bene comune” [5]. Pubblicata oggi, 28 gennaio, la Nota è stata approvata dal Papa.

In 117 paragrafi, Antiqua et Nova (in riferimento alla “sapienza”, antica e nuova) mette in luce sfide e opportunità dello sviluppo dell’Intelligenza Artificiale (IA) nei campi di educazione, economia, lavoro, sanità, relazioni internazionali e interpersonali, contesti di guerra. In quest’ultimo ambito, ad esempio, le potenzialità dell’IA – avverte la Nota - potrebbero accrescere le risorse belliche “ben oltre la portata del controllo umano”, accelerando “una corsa destabilizzante agli armamenti con conseguenze devastanti per i diritti umani” [99].

Pericoli e progressi

Più nel dettaglio, il documento elenca con ragionato equilibrio i pericoli dell’IA ma anche i progressi, che anzi incoraggia come “parte della collaborazione” dell’uomo con Dio “nel portare a perfezione la creazione visibile” [2]. La preoccupazione, tuttavia, è grande ed è quella data da tutte le innovazioni i cui effetti sono ancora imprevedibili, anche per ciò che al momento appare innocuo come la generazione di testi e immagini che rischiano di avere un influsso sulla “crescente crisi di verità” [3].

Distinguere tra IA e intelligenza umana

Dunque sono considerazioni etiche e antropologiche quelle al centro della riflessione dei due Dicasteri che dedicano diversi paragrafi della Nota alla distinzione “decisiva” tra Intelligenza Artificiale e intelligenza umana. Quella che “si esercita nelle relazioni” [18], che è modellata da Dio ed “è plasmata da una miriade di esperienze vissute nella corporeità”. L’IA “manca della capacità di evolversi in questo senso” [31]. E la sua è “una visione funzionalista”, con le persone valutate solo in base a lavori e risultati, laddove la dignità umana è imprescindibile e rimane intatta sempre. Anche in “un bambino non ancora nato”, in “una persona in stato non cosciente” o in “un anziano sofferente” [34]. “Fuorviante”, allora, usare la parola stessa “intelligenza” in riferimento all’IA: non è “una forma artificiale dell’intelligenza”, ma “uno dei suoi prodotti” [35].

Potere in mano di pochi

E come ogni prodotto dell’ingegno umano, anche l’IA può essere diretta verso “fini positivi o negativi”, sottolinea Antiqua et Nova. Non nega, il documento, che l’Intelligenza Artificiale possa introdurre “importanti innovazioni” in vari campi [48] ma avverte dal rischio che essa possa aggravare situazioni di marginalizzazione, discriminazione, povertà, “divario digitale”, disuguaglianze sociali [52]. A sollevare “preoccupazioni etiche” è soprattutto il fatto che “la maggior parte del potere sulle principali applicazioni dell’IA sia concentrato nelle mani di poche potenti aziende” [53], così che questa tecnologia finisca ad essere manipolata per “guadagni personali o aziendali” o ad “orientare l’opinione pubblica verso l’interesse di un settore” [53].

Guerra

La Nota passa al vaglio i vari ambiti del vivere in relazione all’IA. Immancabile il riferimento alla guerra. Mentre le “capacità analitiche” dell’IA potrebbero essere impiegate per aiutare le nazioni a ricercare pace e sicurezza, sono “grave motivo di preoccupazione etica” i sistemi di armi autonome e letali, in grado di “identificare e colpire obiettivi senza intervento umano diretto” [100] e senza alcun tipo di "giudizio morale". Il Papa ha invitato con urgenza a bandirne l’uso, perché come ha detto al G7 in Puglia: “Nessuna macchina dovrebbe mai scegliere se togliere la vita ad un essere umano”. Le macchine in grado di uccidere con precisione in modo autonomo e altre capaci di distruzione di massa sono una minaccia vera e propria per “la sopravvivenza dell’umanità o di intere regioni” [101]. Queste tecnologie “danno alla guerra un potere distruttivo incontrollabile, che colpisce molti civili innocenti, senza risparmiare nemmeno i bambini”, denuncia Antiqua et Nova. Per evitare che l’umanità precipiti in “spirali di autodistruzione”, è necessario allora “assumere una posizione netta contro tutte le applicazioni della tecnologia che minacciano intrinsecamente la vita e la dignità della persona umana”.

Relazioni umane

Sulle relazioni umane il documento osserva che l’IA può, sì, “favorire le connessioni” ma, al contempo, portare a “un dannoso isolamento” [58]. “L’antropomorfizzazione dell’IA”, pure, pone particolari problemi per la crescita dei bambini, incoraggiati a intendere “le relazioni umane in modo utilitaristico”, come avviene con i chatbot [60]. “Erroneo”, poi, rappresentare l’IA come una persona ed è “una grave violazione etica” attuare ciò per scopi fraudolenti. Così come “utilizzare l’IA per ingannare in altri contesti – quali l’educazione o le relazioni umane, compresa la sfera della sessualità – è profondamente immorale e richiede un’attenta vigilanza” [62].

Economia e lavoro

La stessa vigilanza viene domandata in ambito economico-finanziario. In particolare nel campo del lavoro si rileva che se, da una parte, l’IA ha “potenzialità” per accrescere competenze e produttività o per creare nuovi posti di lavoro, dall’altra, può “dequalificare i lavoratori, sottoporli a una sorveglianza automatizzata e relegarli a funzioni rigide e ripetitive” [67], al punto da “soffocare” ogni capacità innovativa. “Non si deve cercare di sostituire sempre più il lavoro umano con il progresso tecnologico: così facendo l’umanità danneggerebbe sé stessa”, sottolinea la Nota [70].

Sanità

Ampio spazio viene dedicato al tema della sanità. Pur detenendo un enorme potenziale in svariate applicazioni in campo medico (ad esempio l’aiuto all’attività diagnostica), l’IA qualora andasse a sostituire la relazione medico-paziente lasciando l’interazione solo alle macchine, rischierebbe di “peggiorare quella solitudine che frequentemente accompagna la malattia”. Pure l’ottimizzazione delle risorse non deve “penalizzare i più fragili” o creare “forme di pregiudizio e discriminazione” [75] che portino a rafforzare una “medicina per i ricchi”, in cui le persone provviste di mezzi finanziari traggono beneficio da strumenti avanzati di prevenzione e informazioni mediche personalizzate, mentre altri faticano ad avere accesso persino ai servizi di base.

Educazione

Rischi vengono evidenziati anche nel campo dell’educazione. Se usata in maniera prudente, l’IA può migliorare l’accesso all’istruzione e offrire “riscontri immediati” agli studenti [80]. Il problema è che molti programmi “si limitano a fornire risposte invece di spingere gli studenti a reperirle da sé, oppure a scrivere essi stessi dei testi”; questo porta a perdere l’allenamento nell’accumulare informazioni o nello sviluppare un pensiero critico [82]. Senza dimenticare quante “informazioni distorte o artefatte” o “contenuti inesatti” alcuni programmi possono generare, andando così a legittimare le fake news [84].

Fake News e Deepfake

A proposito di fake news il documento rammenta il serio rischio che l’IA “generi contenuti manipolati e informazioni false” [85] così da alimentare una “allucinazione” da IA, con contenuti non veritieri che sembrano reali. Ancora più preoccupante è quando tali contenuti fittizi sono usati intenzionalmente a fini di manipolazione. Ad esempio, quando si divulgano intenzionalmente immagini, video e audio deepfake (rappresentazioni modificate o generate da algoritmo) per “ingannare o danneggiare” [87]. L’appello è quindi ad avere sempre “cura di controllare la veridicità” di quanto divulgato e a evitare, in ogni caso, “la condivisione di parole e immagini degradanti per l’essere umano”, escludendo “ciò che alimenta l’odio e l’intolleranza, svilisce la bellezza e l’intimità della sessualità umana, sfrutta i deboli e gli indifesi” [89].

Privacy, controllo, libertà religiosa

Su privacy e controllo, la Nota evidenzia che alcuni tipi di dati possono arrivare a toccare l’intimità della persona, “forse persino la sua coscienza” [90]. I dati ormai si acquisiscono con una minima quantità di informazioni e il pericolo è di far diventare tutto “una specie di spettacolo che può essere spiato, vigilato” [92]. Inoltre, si avverte, “la sorveglianza digitale può essere usata per esercitare un controllo sulla vita dei credenti e sull’espressione della loro fede” [90].

Casa comune

Sul tema Creato vengono giudicate “promettenti” le applicazioni dell’IA per migliorare il rapporto con la casa comune. Basti pensare ai modelli per la previsione di eventi climatici estremi, la gestione dei soccorsi o il supporto all’agricoltura sostenibile [95]. Al contempo, gli attuali modelli di IA e il sistema hardware che li supporta richiedono “ingenti quantità di energia e di acqua e contribuiscono in modo significativo alle emissioni di CO2, oltre a consumare risorse in modo intensivo”. È quindi un tributo “pesante” quello si esige dall’ambiente: “Lo sviluppo di soluzioni sostenibili è vitale per ridurre il loro impatto sulla casa comune”.

Il rapporto con Dio

“La presunzione di sostituire Dio con un’opera delle proprie mani è idolatria”: la Nota cita le Sacre Scritture per mettere in guardia dal fatto che l’IA può risultare “più seducente rispetto agli idoli tradizionali” [105]. Ricorda pertanto che essa non è altro che “un pallido riflesso” dell’umanità: “Non è l’IA a essere divinizzata e adorata, ma l’essere umano, per diventare, in questo modo, schiavo della propria stessa opera”. Da qui, una raccomandazione conclusiva: “L’IA dovrebbe essere utilizzata solo come uno strumento complementare all’intelligenza umana e non sostituire la sua ricchezza” [112].

Salvatore Cernuzio – Città del Vaticano

© www.vaticannews.va, martedì 28 gennaio 2025

Benanti: un documento che aiuta a farci le domande giuste

A colloquio con l’esperto di etica delle tecnologie che studia l’impatto dell’intelligenza artificiale sull’informazione: la Nota dei due Dicasteri invita alla responsabilità

«Un documento che ci dice: questo forse è il tempo di farsi delle domande prima ancora di dare risposte». Con queste parole fra’ Paolo Benanti - docente alla Gregoriana, esperto di bioetica ed etica delle tecnologie, presidente della Commissione per lo studio dell'impatto dell'intelligenza artificiale sul giornalismo e l’editoria della Presidenza del Consiglio italiana - “fotografa” la Nota Antiqua et Nova dei Dicasteri della Dottrina della fede e della Cultura e l'Educazione sul rapporto tra intelligenza artificiale e intelligenza umana. Così lo commenta con i media vaticani.

(LEGGI QUI IL TESTO INTEGRALE DELLA NOTA "ANTIQUA ET NOVA")

Qual è secondo lei la novità di questo documento?

È una presa di coscienza da parte del pensiero credente che ha anche come fine quello di accompagnare la Chiesa nella vita della società. Più noi ci facciamo domande su questa macchina in grado di surrogare parte del decidere umano, più ci stiamo inevitabilmente facendo domande sull’identità stessa dell’essere umano e sull’unicità che lo caratterizza, cioè su ciò che ci fa creature in relazione con un Creatore. La vera novità di questo testo è metterci nella prospettiva corretta per farci delle domande sulla nostra identità e sulle nostre capacità di poter contribuire alla custodia e alla coltivazione del mondo affidateci dal Creatore.

Così l'intelligenza artificiale diventa occasione per farsi delle domande su ciò che realmente siamo noi?

Questa è una grandissima novità: pensiamo che fino a 10/15 anni fa questo tipo di domanda sull’umano sembrava eclissata. Avevamo decisioni politiche che di fatto equiparavano alcune specie di grandi scimmie alla persona umana o che negavano l’identità di persona all’embrione o a chi vive la fase terminale della propria vita. Quella che sembrava una questione da archiviare nel passato, improvvisamente, grazie all’opera dell’uomo, torna prepotentemente nel dibattito pubblico e nell’interesse globale. Questa domanda ha una duplice istanza: da una parte antropologica, come viene ben sottolineato dal documento; dall’altra ha senz’altro delle conseguenze sociali e quindi possiamo già immaginare che sarà sviluppata nell’alveo della Dottrina sociale della Chiesa.

Che differenza c’è fra la cosiddetta intelligenza artificiale e l’intelligenza umana?

Proprio la natura umana - difficilmente contenibile all’interno di una definizione o un perimetro predeterminato - ci porta a dire che quando parliamo dell’uomo parliamo di un qualcosa che è più facile descrivere in tante sue dimensioni. Se noi pensiamo a come i greci parlavano dell'intelligenza, dobbiamo riconoscere che i vocaboli erano “plurali”: Ulisse viene definito “astuto”, “intelligente”, con il vocabolo metis, che indica una forma di intelligenza capace di trovare soluzioni ai problemi pratici. Quando invece si parla dell’intelligenza capace di cogliere il senso del tutto, i greci usano la parola nous. Ecco, già nelle matrici del pensiero occidentale abbiamo un’intelligenza umana plurale, capace di andare in più direzioni. L’intelligenza artificiale non surroga tutte queste forme di intelligenza: è molto brava a vincere dei giochi, a trovare delle soluzioni, è capace di un grande metis. Ma il nous, ciò che cerca il senso del tutto ed è capace di orientare le nostre vite verso un orizzonte, verso un futuro o anche verso la trascendenza, questo è solo umano.

Che cosa dobbiamo temere dalle applicazioni dell’intelligenza artificiale?

Se posso fare una battuta, direi che la prima cosa da temere è la stupidità naturale. Perché la macchina non si mette da sola in grado di surrogare: siamo sempre noi che, a seguito di calcoli o di tentativi di ottimizzare alcuni processi, potremmo utilizzare la macchina facendole scegliere al posto dell’uomo. E una macchina così potente, in grado di scegliere tra infinite opzioni in frazioni di secondo, non sempre è in grado di surrogare quella che umanamente si chiama decisione, cioè qualcosa di connesso alla sapienza. Qui c’è tutta l’ambivalenza dell’IA in grado di fare cose con grande velocità ed efficienza, mentre l’uomo invece è chiamato a interrogarsi sul senso. Forse potremmo o dovremmo temere tutte quelle scelte che non accedono a decisioni. Pensiamo, ad esempio, all’ambito medico: una diagnosi non è mai semplicemente una scelta tra terapie, ma una presa in carico di un’esistenza umana da parte di un’altra esistenza umana che implicitamente gli fa una promessa di cura. Dobbiamo temere tutte quelle situazioni in cui andremmo a vivere un’umanità diminuita per consentire una “macchinalità” aumentata. E promuovere invece tutte le applicazioni che mantengono viva questa responsabilità umana.

Il documento insiste molto sulla responsabilità umana e sulla necessità di rendere conto della decisione presa. Perché?

Ci sono due grandi filoni che danno vita alla bella risposta presente in questo documento. C’è un filone che parte dall’ottica di fede e si interroga su quale sia la specificità umana dal punto di vista della coscienza. La costituzione conciliare Gaudium et Spes ci parla di quel luogo intimo dentro di noi dove noi sentiamo una voce che in alcuni momenti ci dice: fai questo ed evita quest’altro. È il sacrario dove l’uomo avverte la voce di Dio. Ecco la matrice della responsabilità. Ma all’interno di questa consapevolezza credente c’è anche tutta una consapevolezza dell’effetto di sottrarre responsabilità al decidere umano. Grandi scrittori come Hannah Arendt hanno parlato di come, nei grandi eccidi del secolo scorso, si è cercato di sottrarre responsabilità al decidere umano per diventare parte di un ingranaggio che porta alla massima disumanizzazione personale e sociale. Queste due capacità umane, fede e ragione, dandosi la mano, possono aiutarci a vedere come innovare l’intelligenza artificiale così che possa diventare davvero fonte di sviluppo umano.

Purtroppo continuiamo a vedere il ruolo delle armi autonome. Che cosa possiamo dire dell’applicazione dell’intelligenza artificiale alla guerra?

Pensiamo a noi 60.000 anni fa, quando in una caverna abbiamo preso in mano per la prima volta una clava. Era un utensile per avere più noci di cocco e un'arma per aprire più crani di altre persone. Tutte le volte che siamo davanti a una tecnologia, siamo davanti alla tentazione di trasformare un utensile in un’arma. Ma siamo anche inseriti in una storia di salvezza - ricordiamo il profeta Isaia - nella quale le armi possono diventare utensili da usare per coltivare, per sfamare e dare vita. In questa nostra storia di peccato e conversione, chi fa la guerra ha la fortissima tentazione di usare strumenti con una tecnologia così potente. Vorrei ricordare che l’IA non è la prima forma di tecnologia autonoma utilizzata in guerra. Pensiamo alle mine anti-uomo: sono autonome! Un sistema di intelligenza artificiale lo possiamo definire qualcosa che può prendere dall’umano un fine, e poi adegua i mezzi per ottenere quel fine. Mai come in guerra vediamo però che i mezzi non sono tutti uguali: a partire dalla grande tragedia atomica, ci siamo resi conto dell’esistenza di mezzi da evitare ad ogni costo. Una macchina, a differenza dell’essere umano, non si stancherà mai di perseguire il suo obiettivo e quindi potrebbe non esserci mai una tregua se ci si affida solo alle macchine. Quanta più è la capacità dell'uomo, tanto più radicali si fanno le domande alle quali dobbiamo rispondere.

Intervenendo al G7 dello scorso anno, Papa Francesco ha detto che mai dovrebbe essere lasciata a una macchina la decisione di togliere una vita umana.

Una voce profetica quella del Papa. Una voce fortissima che indica una direzione. Abbiamo bisogno di un’estrema precauzione, o meglio, per usare le parole del documento, di un’estrema responsabilità.

L’intelligenza artificiale oggi consente di falsificare la rappresentazione della realtà. Pensiamo alle immagini false o ritoccate sempre meno distinguibili da quelle vere. O alla diffusione massiccia delle fake news. Come possiamo contrastare queste derive?

Sembra che per qualcuno la verità sia diventata qualcosa di secondario e che siano possibili narrazioni completamente sganciate dai fatti. Tutte le democrazie occidentali si fondano su una premessa fondamentale: esse possono esistere come democrazie se le persone sono in grado di farsi un’opinione corretta sui fatti. Quindi la democrazia dà al giornalista quasi un ruolo di civil servant: la sua professionalità è simile a quella dello scienziato che cerca la verità o del giudice che cerca di appurare i fatti. L’intelligenza artificiale potrebbe rendere molto meno costosi alcuni processi di produzione di alcuni tipi di informazione, ma non per questo sarebbero più veri né più utili. Per vivere in una democrazia abbiamo bisogno del giornalismo professionale, e il giornalismo professionale ha bisogno di un settore industriale. Tutto ciò può essere danneggiato economicamente, o distrutto nella sua capacità, da un’intelligenza artificiale nelle mani sbagliate o con finalità sbagliate.

Come tutelarci?

Il documento ci ricorda la categoria chiave della responsabilità e ci sono forme di responsabilità che nello spazio pubblico assumono la consistenza del diritto. Forse è arrivato il momento di insistere perché esista un diritto “cognitivo” delle persone: quello di sapere quali contenuti sono stati elaborati da un essere umano che ci mette la sua responsabilità professionale, e quali invece sono stati prodotti da una macchina. Dobbiamo forse definire un paio di guardrail per tenere in carreggiata il servizio alla verità dell’informazione e del giornalismo. Il documento ci dice che questo forse è il tempo di farsi delle domande, prima ancora di dare risposte.

Andrea Tornielli

© www.vaticannews.va, martedì 28 gennaio 2025

L’IA, strumento che non sostituisce la ricchezza dell’umano

Punti fermi del nuovo documento sull’intelligenza artificiale dei Dicasteri per la Dottrina della fede e per la Cultura e l'Educazione

Ad essere fuorviante è innanzitutto il nome. Quello della cosiddetta “Intelligenza artificiale” è uno di quei casi in cui il nome ha contato e conta molto nella comune percezione del fenomeno. La Nota Antiqua et nova (LEGGI QUI SINTESI E TESTO INTEGRALE) dei Dicasteri per la Dottrina della fede e per la Cultura e l'Educazione ci ricorda innanzitutto che l’IA è uno strumento: esegue compiti, ma non pensa. Non è in grado di pensare. È dunque ingannevole attribuirle caratteristiche umane, perché si tratta di una “macchina” che rimane confinata nell’ambito logico-matematico. Non possiede cioè una comprensione semantica della realtà, né una capacità autenticamente intuitiva e creativa. Non è in grado di replicare il discernimento morale o un’apertura disinteressata a ciò che è vero, buono e bello, al di là di ogni utilità particolare. Insomma, le manca tutto ciò che è veramente e profondamente umano.

L’intelligenza umana è infatti individuale e insieme sociale, razionale e allo stesso tempo affettiva. Vive attraverso continue relazioni mediate dalla insostituibile corporeità della persona. L’IA dovrebbe dunque essere utilizzata solo come uno strumento complementare all’intelligenza umana, e non pretendere di sostituirne in qualche modo la peculiare ricchezza.

Nonostante il progredire della ricerca e delle sue possibili applicazioni, l’IA continua a rimanere una “macchina” che non ha responsabilità morale, quella responsabilità che permane invece su coloro che la progettano e la utilizzano. Per questo, sottolinea il nuovo documento, è importante che quanti prendono decisioni in base all’IA siano ritenuti responsabili per le scelte fatte, e che sia possibile rendere conto dell’uso di questo strumento in ogni fase del processo decisionale. Sia i fini che i mezzi utilizzati nelle applicazioni dell’IA devono essere valutati per assicurarsi che rispettino e promuovano la dignità umana e il bene comune: questa valutazione costituisce un criterio etico fondamentale per discernere la legittimità o meno dell’uso dell’intelligenza artificiale.

Un altro criterio di valutazione morale dell’IA, suggerisce la Nota, riguarda la sua capacità di implementare la positività delle relazioni che l’uomo ha con il suo ambiente e con quello naturale, di favorire una costruttiva interconnessione dei singoli e delle comunità ed esaltare una responsabilità condivisa verso il bene comune. Per raggiungere questi obiettivi è necessario andare oltre la mera accumulazione di dati e di sapere, adoperandosi per raggiungere una vera “sapienza del cuore”, così come suggerisce Papa Francesco, affinché l’uso dell’intelligenza artificiale aiuti l’essere umano a diventare effettivamente migliore.

In questo senso, la Nota mette in guardia da qualsiasi subalternità alla tecnologia invitando ad utilizzarla non per sostituire progressivamente il lavoro umano – fatto che creerebbe nuove forme di emarginazione e di disuguaglianza sociale – ma piuttosto come strumento per migliorare l’assistenza e arricchire i servizi e la qualità delle relazioni umane. E anche come aiuto nella comprensione di fatti complessi e guida nella ricerca della verità. Per questo, il contrasto alle falsificazioni alimentate dall’IA non è un lavoro soltanto per gli esperti del settore, ma richiede gli sforzi di tutti.

Bisogna anche evitare che l’intelligenza artificiale sia impiegata come forma di sfruttamento o per limitare la libertà delle persone, per avvantaggiare pochi a spese di molti, o come forma di controllo sociale, riducendo le persone ad un insieme di dati. E non è accettabile che in ambito bellico si affidi a una macchina la scelta di togliere vite a degli esseri umani: purtroppo abbiamo constatato di quante e quali devastazioni siano responsabili le armi guidate dall’intelligenza artificiale, come tragicamente dimostrato nei tanti conflitti in atto.

Andrea Tornielli

© www.vaticannews.va, martedì 28 gennaio 2025

Tighe: “Antiqua et nova” offre una guida sugli sviluppi etici dell’IA

Il segretario del Dicastero per la Cultura e l'Educazione illustra il documento vaticano sull’Intelligenza Artificiale sottolineandone il grande potenziale e nello stesso tempo evidenziando la necessità che l'umanità ne guidi lo sviluppo attraverso una responsabilità collettiva per il bene di tutti

Un contributo al dibattito sul tema dell'IA, offrendo una guida etica e spunti di riflessione. Così il vescovo Paul Tighe, segretario del Dicastero per la Cultura e l’Educazione, sintetizza il documento Antiqua et nova: Nota sul rapporto tra l’intelligenza artificiale e l’intelligenza umana pubblicato oggi, 28 gennaio, dal suo Dicastero e quello per la Dottrina della Fede. Parlando ai media vaticani, Tighe sottolinea che con la Nota si desidera contribuire al dibattito sul tema dell'IA offrendo una guida etica e degli spunti di riflessione. “C’è una comprensione più ampia dell’intelligenza – afferma – che ha a che fare con la nostra capacità umana di trovare nelle nostre vite uno scopo e un significato, e questa è una forma di intelligenza che le macchine non sono proprio in grado di sostituire”. Di seguito pubblichiamo una traduzione dall’inglese di alcuni stralci dell’intervista a monsignor Tighe (QUI INTEGRALE IN INGLESE).

Cosa c’è di “nuovo” in questo documento e cosa spera di comunicare al mondo, in particolare alla Chiesa?

Il documento riunisce molte riflessioni che sono state sviluppate in maniera organica in questi ultimi anni. Quello che cerca di fare è offrire alle persone alcune prospettive da cui poter iniziare a pensare in modo critico all'IA e ai suoi potenziali benefici per la società, e poi allertare le persone su ciò a cui dobbiamo prestare attenzione per assicurarci di non aver creato inavvertitamente qualcosa che potrebbe essere dannoso per l'umanità e la società. Mi verrebbe da dire che c’è un certo elemento di cautela qui. Tanti di noi, con l’avvento dei social media, sono stati velocissimi nello sposare il loro straordinario potenziale. E forse non abbiamo visto invece quali potevano essere i risvolti negativi in termini di polarizzazioni, fake news e altre questioni. Vogliamo accogliere un qualcosa che ha un enorme potenziale per l’essere umano: vogliamo vedere questo potenziale, ma al tempo stesso prestare attenzione ai possibili effetti controproducenti. E penso che questo è quello che stiamo cercando di fare qui. Un giorno leggiamo sui titoli dei quotidiani che l’IA sarà la salvezza di noi tutti e il giorno dopo che causerà l’annientamento e la fine del mondo. Cerchiamo di offrire alle persone un approccio più equilibrato. Il documento si sofferma su una serie di punti. Ci sono alcune questioni principali legate al futuro dell’occupazione, alla guerra, le deepfake e le disuguaglianze. Ci sono questioni etiche e questioni sociali sulle quali vogliamo soffermarci. Tuttavia, nell’affrontare questi temi, cerchiamo al tempo stesso di interrogarci e focalizzarci su una questione che è più alla base, ovvero sulla questione antropologica del cosa significhi essere umani. Che cos’è che dà alla vita umana un valore, uno scopo, un significato? Noi riconosciamo che i sistemi dell’IA possono rafforzare e migliorare alcuni aspetti della nostra umanità, come la nostra capacità di ragionare, di elaborare, discernere, scoprire, scorgere strade, generare innovazioni. Quello che noi vogliamo affermare è che esiste una comprensione più ampia dell’intelligenza che ha a che vedere con la nostra capacità umana di trovare uno scopo e un significato nella vita. Parte della domanda che ci dobbiamo porre è la seguente: che cos’è che è un bene per l’umanità? Che cos’è che incoraggia il benessere dell’essere umano? E questa è una forma di intelligenza che le macchine non sono proprio in grado di sostituire. Nella tradizione cattolica la maniera in cui noi intendiamo l’intelligenza è più di un semplice ragionare, calcolare ed elaborare, ma comprende anche la nostra capacità di andare alla ricerca di uno scopo, di un significato e di una direzione nelle nostre vite. Penso che ciò che ci preoccupa sempre sia la ricerca della verità ultima, di cosa è che dà forma, scopo e significato alla vita. Quindi possiamo usare l'IA per far sì che questa ci aiuti in alcuni aspetti ma, in ultima analisi, la nostra dimensione intellettuale va al di là qualcosa che può essere svolto semplicemente da una macchina.

Lo sviluppo dell’IA va avanti a rapidi passi. Perché i Dicasteri per la Dottrina della Fede e per la Cultura e l'Educazione hanno deciso di rilasciare la Nota in questo momento?

Di certo, dal nostro punto di vista, per quanto riguarda il mondo dell’educazione, tutti gli educatori si stanno ponendo domande su quale sia il potenziale dell’IA nell’ottica di un supporto all’educazione e sui rischi di una qualche spersonalizzazione, a causa di quest’ultima, della natura stessa dell’educazione. Stiamo al tempo stesso rispondendo alle domande che ci vengono poste durante le visite ad limina, perché i vescovi hanno bisogno di una qualche indicazione al riguardo. Il documento nasce da questo e raccoglie e mette insieme molte altre iniziative. Esso inoltre offre un’unità di visione, che cerca di unire le questioni etiche e collegarle a quella visione antropologica più fondamentale di ciò che ci rende umani. L’Unesco ha affermato che – e questo è quello che mi ha colpito di più – sta portando a quella che loro definiscono una “disruptio antropologica”. La Silicon Valley ama il linguaggio della rottura, del fare in pezzi per reinventare. Tuttavia qui, quando parliamo della natura di ciò che è un essere umano è molto importante che riflettiamo in maniera critica su questo senza bypassare la domanda sul significato ultimo della vita. E qui penso che le questioni che emergono fortemente in questo documento riguardano il rischio di una disuguaglianza che aumenta con l’IA. Ciò si può vedere, in generale, da ciò che è successo con la digitalizzazione, che ha portato all'aumento di un numero molto piccolo di persone straordinariamente ricche, con enormi quantità di potere, e che non necessariamente sono responsabili nei confronti di altre istituzioni. Quindi, come pensiamo di fare in modo che tutto ciò non contribuisca a fratturare l'unità della famiglia umana, che deve essere unita anche nell’accesso al potere e alle informazioni? Un ambito in cui l'IA ha un potenziale straordinario è quello della salute. Ma sappiamo che la sanità già tende ad essere distribuita in maniera non molto equa. L’IA porterà a ulteriori disuguaglianze in questo settore? Una gran parte delle nostre riflessioni affrontano questi temi.

Quando si pensa alla relazione dell'umanità con l'IA vengono in mente i racconti di fantascienza di Isaac Azimov, Il Ciclo dei Robot. Secondo lei questa Nota adotta un punto di vista più favorevole o più cauto nei confronti dell'Intelligenza Artificiale?

Mi auguro che adotti un punto di vista che si situi nel mezzo, ovvero che non abbracci nessuna delle due visioni apocalittiche. E neanche sta provando ad immaginare che, da sola, l’IA sarà alla base della soluzione di tutti i problemi dell’umanità. Sta cercando di vedere il potenziale che l'IA rappresenta. È una riflessione sulla capacità che ha l’umanità di imparare, di innovare, di svilupparsi, che è una capacità che ci è data da Dio. Noi vogliamo celebrare tutto questo. Nello stesso tempo, conosciamo tante straordinarie innovazioni che nel passato avevano un enorme potenziale, ma che poi si sono rivelate problematiche per una serie di motivi. Problematiche perché forse sussistevano intrinseci difetti nei sistemi stessi. Problematiche perché le persone potevano usare la stessa tecnologia per cose molto buone ma al tempo stesso per raggiungere scopi molto brutti. A volte problematiche perché i sistemi - e qui stiamo pensando all’IA - sono stati sviluppati in un particolare contesto commerciale e politico e potrebbero già essere segnati dai valori propri di quegli ambienti.

Vogliamo sviluppare un pensiero critico e far sì che l'IA sia uno strumento che possa essere usato dall'umanità in modo tale che realizzi il suo potenziale benefico per tutti gli esseri umani. L’umanità la bisogno di avere il controllo dei processi e deve prestare attenzione a che ci sia un senso di responsabilità. E qui è dove i racconti de “Il Ciclo dei Robot” di Azimov entrano in gioco. Dove risiederà la responsabilità?

Le macchine dell’IA faranno cose straordinarie. Ci saranno delle volte in cui non riusciremo a capire come le stanno facendo. Stanno sviluppando una capacità di riprogrammarsi e di avanzare da sole. Quindi, quello che dobbiamo fare è cercare di capire: dove risiede la responsabilità? Nel settore, molti ora parlano di un’IA che è "etica per progettazione" (“ethical by design”). Quindi dovremmo pensare fin dall'inizio: quali sono i problemi? Quali sono le difficoltà? Come possiamo pianificare le cose in modo tale da evitare i problemi? Quindi, tutto ciò significa: come facciamo a renderla sicura, in modo che funzioni bene, che non abbia malfunzionamenti? Come facciamo a garantire che non venga facilmente sfruttata da persone che potrebbero usarla per scopi negativi? Come facciamo ad assicurare che l’IA sia qualcosa che rispecchi il meglio di noi in quanto esseri umani?

Per questo motivo, cerchiamo sempre di ritenere responsabili chi progetta, pianifica, sviluppa, ma anche chi utilizza l’IA.

Se potesse mettere in luce un aspetto di questo documento, quale sarebbe?

Quello che vorrei dire alle persone che si troveranno a leggere questo testo è che, sia che siano cattoliche o che non lo siano, l’obiettivo è quello di essere il più informati possibile su ciò che sta succedendo in questo momento, senza sentirsi impotenti o esclusi. Lo dico da persona che ha già percorso un bel tratto di vita, e lo sto dicendo alla mia generazione, per non sentirsi come se ci stessimo tirando indietro. Una cosa che direi alle persone è di cominciare ad usare le tecnologie, esplorarle, vedere quanto esse sono straordinarie, ma allo stesso tempo iniziare a sviluppare un punto di vista critico nei loro confronti, imparare come riuscire a valutarle e riflettere su di esse.

Un aspetto che prenderei del documento è l’importanza della responsabilità. Ognuno dovrebbe pensare al proprio grado di responsabilità - e ciò riguarda e si estende anche all’utente - e domandarsi: inizierò a condividere contenuti che so essere dubbi o che immagino potrebbero incitare all’odio? E così assumermi la responsabilità per come uso l’IA.

Devin Watkins - Città del Vaticano

© www.vaticannews.va, martedì 28 gennaio 2025